前回の続きです。

まず、YouTubeでもなんでもいいので、ライブ配信をすることを考えます。

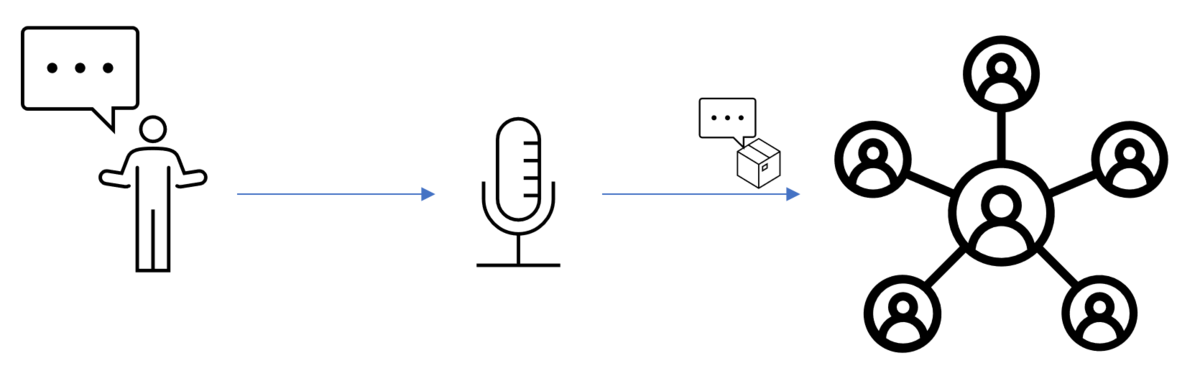

普通は自分の声をマイクで録って、OBSでもなんでも、配信用のソフトウェアから全世界の視聴者に向けて発信します。

でも、シャイな配信者は、自分の声をそのまま発信したくありません。

だからと言って、ボイスチェンジャーでは声質から本人の特徴をつかまれてしまいます。

そして何より、私のように活舌が悪い人にとっては、ボイスチェンジャーを使ったところで聞き取りづらい音声になることに変わりありません。

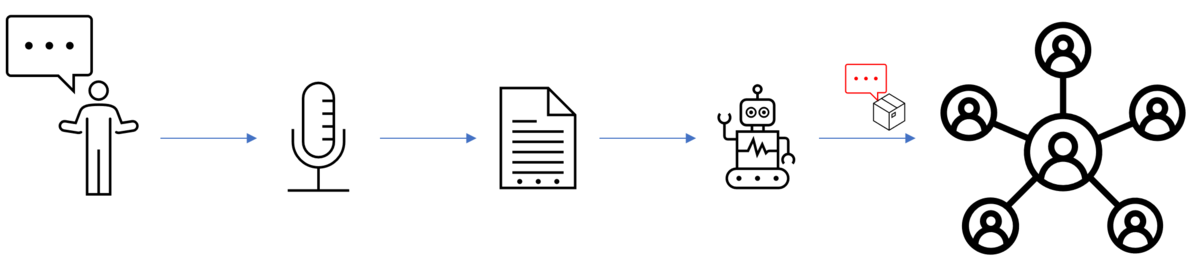

そこで、マイクを通して入力した自分の声を、一度日本語音声認識ソフトでテキストに起こして、これを音声合成ソフトで発声します。音声合成ソフトから発された音を、全世界の視聴者に向けて発信することで、自分の声の特徴をつかまれないほか、はっきりと聞き取りやすい声を視聴者に届けることができます。

このとき、あまりにも活舌が悪いと、日本語音声認識ソフトが誤認識をする場合があります。ただしこれは、誤認識という、機械的な認識においてはありがちなものであって、人間の発声した内容を音声合成ソフトで読み上げるという一連のシステムを成立させないものではないため、ここでは問題にしません!

そもそも、正確な音声認識自体、まだ途上なものです。たとえば、Abema TVのAIポンと呼ばれる同時字幕表示機能は、実際のオンエアですでに運用されているものの、音声認識自体の精度は完全ではありません。大手ITサービスの商業運用においてもこれが認められているのだから、一般ユーザーユースの本研究テーマにおいて、認識そのものに焦点をあてるのは不適切です。

認識の問題を問わず、単純に人間が発声した内容を、音声合成ソフトで読み上げて、これを配信する。

この一連のシステムを成す、カンタンなソフトウェアを実装してみようというのが、今回の連載のテーマになります。

先の例では、システム系の中で処理しなければならない工程がないため、発声した音声はリアルタイムで配信することができます。

一方、あいだに日本語認識や音声合成をはさむ本システムでは、それぞれの作業工程があるため、発声からいくらかの時間(現時点では程度は不明)をおいて配信されることになります。

この遅延がどの程度のものになるかは分かりませんが、どれだけの遅延であっても本システムとしては許容するものとします。

つまり、平均的な遅延時間から映像側をある程度遅らせて、疑似的に同期をとるとか、いくらでもやりようがあるので、その程度の努力はしてくださいね、ということです。

で、ここまで語りましたが、この記事の執筆時点で、まだ成果物はできていません。

というか、この記事を書きながら成果物を作ろうとしています。

そのため、どこかのタイミングでシステムとして成しえなかったとしても、それは仕方がなかったということで、ゆるしてちょんまげ(´・ω・`)

ちょうどいい長さなのでいったんここで区切ります。

次からは実際のプログラミングに入ります。